- 1. Pendahuluan

- 2. Dataset Awal

- 3. Import Data ke OpenRefine

- 4. Standarisasi Penulisan Nama Kota

- 5. Penyeragaman Format Tanggal Transaksi

- 8. Export Data Bersih

- 7. Pembersihan Data dan Validasi Dataset

- 8. Penghapusan Data Duplikat

- 9. Dataset Bersih dan Kesiapan Penggunaan Data

- 10. Kesimpulan Tahap Pembersihan Data

1. Pendahuluan

Dalam pengolahan data, data mentah (raw data) sering kali memiliki berbagai permasalahan seperti format yang tidak konsisten, duplikasi data, serta kesalahan penulisan. Jika data tersebut langsung digunakan tanpa proses pembersihan, maka hasil analisis yang diperoleh dapat menjadi tidak akurat.

Oleh karena itu, pada tugas ini dilakukan proses pembersihan data transaksi alat tulis kantor (ATK) menggunakan aplikasi OpenRefine. OpenRefine dipilih karena mampu membantu proses data cleaning secara efisien tanpa memerlukan pemrograman yang rumit. Proses pembersihan meliputi penyeragaman format tanggal, standarisasi penulisan nama kota, serta penghapusan data duplikat. Hasil akhir berupa dataset bersih yang siap digunakan di Google Sheets.

2. Dataset Awal

Dataset yang digunakan pada tugas ini merupakan data transaksi ATK yang disimpan dalam format CSV. Data ini masih berupa data mentah dan memiliki beberapa permasalahan, di antaranya:

- Format tanggal transaksi yang berbeda-beda

- Penulisan nama kota yang tidak konsisten

- Data masih belum melalui proses validasi

Sebelum dibersihkan, dataset ini langsung dimasukkan ke dalam OpenRefine untuk dilakukan proses pembersihan.

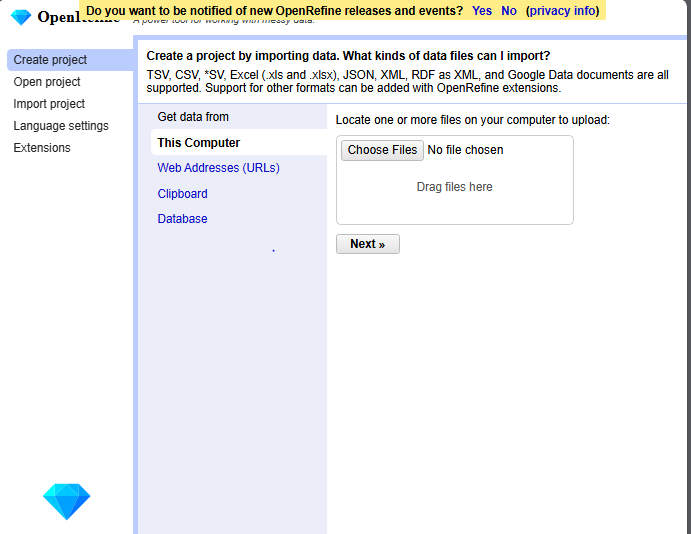

3. Import Data ke OpenRefine

Langkah pertama dalam proses pembersihan data adalah mengimpor dataset ke dalam OpenRefine.

Langkah-langkah yang dilakukan adalah sebagai berikut:

- Membuka aplikasi OpenRefine

- Memilih menu Create Project

- Memilih opsi This Computer

- Mengunggah file dataset transaksi dalam format CSV

- Klik Next untuk melihat preview data

- Memberi nama project dengan nama transactions_clean

- Klik Create Project

Setelah proses ini, dataset berhasil dimuat ke dalam OpenRefine dan siap untuk diproses lebih lanjut.

4. Standarisasi Penulisan Nama Kota

Pada kolom city, ditemukan beberapa variasi penulisan nama kota seperti “Jakarta”, “jakarta”, “JKT”, dan “jkt”. Jika tidak diseragamkan, maka data tersebut akan dianggap sebagai entitas yang berbeda.

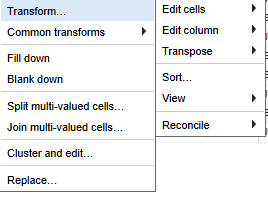

Untuk mengatasi permasalahan tersebut, dilakukan proses standarisasi penulisan nama kota dengan langkah-langkah berikut:

1.)Klik dropdown pada kolom city :

2.) Pilih Facet → Text Facet

OpenRefine akan menampilkan seluruh variasi penulisan nama kota

Melakukan penyamaan penulisan sehingga seluruh data kota menjadi satu format, misalnya “Jakarta”

Dengan langkah ini, penulisan nama kota menjadi konsisten di seluruh dataset.

Contoh yang sudah di ganti :

5. Penyeragaman Format Tanggal Transaksi

Kolom transaction_date pada dataset memiliki format tanggal yang berbeda-beda, seperti YYYY-MM-DD, DD-MM-YYYY, dan YYYY/MM/DD. Perbedaan format ini dapat menyebabkan kesalahan dalam pengolahan data selanjutnya.

Untuk menyeragamkan format tanggal, dilakukan langkah-langkah berikut:

1.) Klik dropdown pada kolom transaction_date

2.) Pilih Edit cells → Transform

Melakukan transformasi sehingga seluruh tanggal menggunakan satu format yang sama, yaitu YYYY-MM-DD :

Setelah proses ini selesai, seluruh data tanggal transaksi memiliki format yang seragam.6. Import Data ke Google Sheets

8. Export Data Bersih

Setelah dataset dinyatakan bersih, data diekspor kembali ke dalam format CSV agar dapat digunakan pada aplikasi lain.

Langkah-langkah export data:

- Klik menu Export pada OpenRefine

- Pilih format CSV

- Simpan file dengan nama transactions_clean.csv

File ini merupakan hasil akhir dari proses pembersihan data menggunakan OpenRefine

7. Pembersihan Data dan Validasi Dataset

Setelah proses standarisasi pada kolom tanggal transaksi dan nama kota selesai dilakukan, tahap selanjutnya adalah melakukan validasi terhadap keseluruhan dataset. Validasi data bertujuan untuk memastikan bahwa data yang telah dibersihkan benar-benar konsisten, akurat, dan siap digunakan untuk kebutuhan analisis maupun pengembangan aplikasi.

Pada tahap ini, dilakukan pengecekan ulang terhadap nilai-nilai pada setiap kolom untuk memastikan tidak terdapat kesalahan penulisan, data kosong yang tidak semestinya, maupun ketidaksesuaian format. Dengan dilakukannya validasi data, kualitas dataset dapat terjaga sehingga meminimalkan risiko kesalahan pada tahap pengolahan data berikutnya.

8. Penghapusan Data Duplikat

Data duplikat merupakan salah satu permasalahan umum dalam dataset transaksi. Keberadaan data duplikat dapat menyebabkan hasil analisis menjadi tidak akurat, terutama pada perhitungan jumlah transaksi, total penjualan, maupun analisis frekuensi data.

Oleh karena itu, setelah data dinyatakan konsisten dari segi format tanggal dan penulisan nama kota, dilakukan penghapusan data duplikat. Proses ini bertujuan untuk memastikan bahwa setiap transaksi hanya tercatat satu kali dalam dataset. Dengan dihilangkannya data duplikat, dataset menjadi lebih valid dan representatif terhadap kondisi transaksi yang sebenarnya.

9. Dataset Bersih dan Kesiapan Penggunaan Data

Setelah melalui proses pembersihan dan validasi, dataset yang dihasilkan dapat dikategorikan sebagai data bersih (clean data). Dataset ini telah memiliki format yang konsisten, tidak mengandung duplikasi, serta siap digunakan untuk berbagai kebutuhan lanjutan.

Data bersih ini kemudian dapat dimanfaatkan untuk proses analisis data, visualisasi, maupun sebagai sumber data utama dalam pengembangan aplikasi berbasis Google Sheets dan AppSheet. Ketersediaan data yang rapi dan terstruktur menjadi fondasi penting dalam membangun sistem informasi yang akurat dan andal.

10. Kesimpulan Tahap Pembersihan Data

Tahap pembersihan data merupakan langkah krusial sebelum data digunakan lebih lanjut. Dengan melakukan standarisasi, validasi, dan penghapusan duplikasi, kualitas dataset dapat ditingkatkan secara signifikan. Data yang telah dibersihkan tidak hanya lebih mudah dianalisis, tetapi juga lebih aman digunakan sebagai basis pengambilan keputusan dan pengembangan aplikasi.